Kausale Annahmen für (Regressions) Modelle;

Mediation & Pfadmodelle

Methoden II: Methoden der empirischen Kommunikations- und Medienforschung

Freie Universität Berlin

26. 05. 2025

Update zur Klausur

In diesem Jahr noch keine eigene Ausführung von R oder RStudio während der Klausur.

Aber Screenshots von Code und Output → Lesen, Verstehen, Interpretieren, Kritisieren

Ab sofort auch gerenderte Lösung direkt in Blackboard verfügbar (Minimalanforderung: Diese Lesen und inhaltlich Nachvollziehen).

Wenn Sie Interesse an Anwendungskompetenz haben, sollten Sie die Übungsaufgaben trotzdem selbst ausführen.

Fragen zur Übung?

Agenda

- Kausale Annahmen für (Regressions) Modelle

- Mediation & Pfadmodelle

- Ausblick (optional): Messmodelle in Strukturgleichungsmodellen

- Übungen

Lernziele

- Lernziel der Vorlesungssitzung: Ergebnisse einer multiplen Regression und einer mit einem Strukturgleichungsmodell geschätzten Mediationsanalyse vor dem Hintergrund kausaler Annahmen lesen, verstehen, formulieren, kritisieren können

- Lernziel der Übungsaufgabe: R-Code zur Mediationsanalyse mit Strukturgleichungsmodellen in

{lavaan}nachvollziehen, ausführen und bearbeiten können

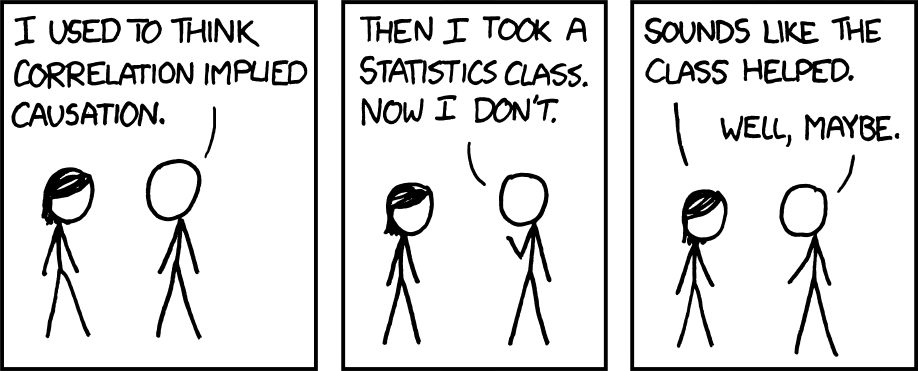

Korrelation Kausalität - oder doch?

Minimale Annahmen für kausale Effekte

Zusammenhang: Es besteht nach angemessener Modellierung ein Zusammenhang zwischen uV und aV

Zeitliche Reihenfolge: uV liegt zeitlich vor aV

Keine plausiblen alternativen Erklärungen: alle und nur die relevanten Drittvariablen wurden gemessen und im Modell berücksichtigt

Randomisiertes Treatment im Experiment

Zusammenhang: z.B. Regressionskoeffizient des Indikators für Experimentalgruppe vs. Kontrollgruppe

Zeitliche Reihenfolge: Erst Treatment, dann aV

Keine plausiblen alternativen Erklärungen: uV ist durch Design mit keinen anderen gemessenen oder nicht gemessenen Variablen korreliert; keine alternativen Erklärungen möglich

Nicht experimentelle Designs (?)

Zusammenhang: z.B. Koeffizient der uV aus multipler Regression

Zeitliche Reihenfolge: Längsschnitt oder Theorie

Keine plausiblen alternativen Erklärungen: Messen und Berücksichtigen aller wichtigen und richtigen Variablen im Regressionsmodell

- Identifikation kausaler Effekte basiert größtenteils auf (nicht direkt testbaren) Annahmen → Theorie!

Arten von Variablen in kausalen Modellen

- Variablen, für die wir uns interessieren

- uV: unabhängige Variable, von der ein kausaler Effekt ausgeht

- aV: abhängige Variable, die von uV beeinflusst wird

- Drittvariablen (für deren Effekte wir uns erst einmal nicht interessieren, deren Effekte aber die Identifikation des Effekts von Interesse stören können)

- Confounder

- Collider

- Mediator

Confounder

- uV: unabhängige Variable, von der Effekt ausgeht

- aV: abhängige Variable, die von uV beeinflusst wird

- Confounder: Variable, die uV und aV beeinflusst.

- Kausale Effekte des Confounder führen zu Zusammenhang zwischen uV und aV (“Scheinkorrelation”)

- Kontrolle des Confounder nötig, um beobachteten Zusammenhang zu entfernen

- Typisches Problem: Unbekannte oder nicht gemessene Confounder (“omitted variable bias”)

Wahres kausales Modell

Folgen bei falscher Spezifikation

Confounder – Beispiel

Wahres kausales Modell

Folgen bei falscher Spezifikation

Collider

- uV: unabhängige Variable, von der Effekt ausgeht

- aV: abhängige Variable, die von uV beeinflusst wird

- Collider: Variable, die von uV und aV beeinflusst wird.

- Kontrolle des Collider nicht erlaubt

- Typisches Problem: Kontrolle (oder andere Berücksichtigung) von Collider führt zu beobachtetem Zusammenhang zwischen kausal unabhängigen uV und aV (“collider bias”)

Wahres kausales Modell

Folgen bei falscher Spezifikation

Collider – Beispiel

Wahres kausales Modell

Folgen bei falscher Spezifikation

Mediator

- uV: unabhängige Variable, von der Effekt ausgeht

- aV: abhängige Variable, die von uV beeinflusst wird

- Mediator: Variable, die von uV beeinflusst wird und dann wiederum aV beeinflusst.

- Kontrolle des Mediator nicht erlaubt, wenn wir gesamten kausalen Effekt von uV auf aV schätzen wollen.

- Analyse mit Mediator manchmal gewünscht, wenn wir den Prozess uV → Mediator → aV untersuchen wollen (“indirekter Effekt”)

- Typisches Problem: Kontrolle von Mediator unterschätzt den kausalen Effekt von uV und aV

Interessanter kausaler Effekt

Folgen bei unpassender Spezifikation

Mediator – Beispiel

Interessanter kausaler Effekt

Folgen bei unpassender Spezifikation

Zusammenfassung

| Wahrer kausaler Prozess | Zusammenhang zwischen uV und uV ohne Kontrolle | Zusammenhang zwischen uV und aV bei Kontrolle der mittleren Variable |

|---|---|---|

| aV ← Confounder → uV | Nicht-kausaler Zusammenhang | Kein Zusammenhang |

| aV → Collider ← uV | Kein Zusammenhang | Nicht-kausaler Zusammenhang |

| uV → Mediator → aV | Kausaler Zusammenhang | Kein (oder geringerer) Zusammenhang |

Zwischenfazit

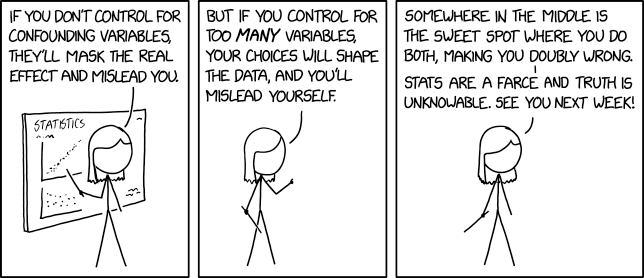

- Die Spezifikation eines passenden Modells zur Identifikation eines kausalen Effekts erfordert starke, häufig vor allem theoretisch zu begründende Annahmen.

- Falsche Spezifikation des kausalen Modells führt zu inhaltlich falschen Schlüssen. Ergebnisse eines Regressionsmodells beruhen auf der Annahme, dass das zugrunde liegendes Modell richtig abgebildet wurde.

- Überspezifizierte “große” Regressionsmodelle mit möglichst vielen Kontrollvariablen (“um ganz sicher zu gehen habe ich alles denkbare kontrolliert”; a.k.a. “kitchen sink regression”, “causal salad”) ohne Nachdenken über kausale Annahmen

- → Gefahr von Collider- und Mediator-Variablen im Modell

- → “overadjustment bias”

- Unterspezifizierte “sparsame” Regressionsmodelle mit nur wenigen Kontrollvariablen (“aber ich wollte es doch einfach und übersichtlich halten”) und ohne Identifikation durch Studiendesign

- → Gefahr von fehlenden Confounder-Variablen im Modell

- → “omitted variable bias”

Zwischenfazit

Fragen?

Mediation & Pfadmodelle

Mediation & Pfadmodelle

Mediator: Variable, die von uV beeinflusst wird und dann wiederum aV beeinflusst

Die Mediationsanalyse interessiert sich für diesen kausalen Prozess. Sie will erklären, wie oder warum eine uV einen Effekt auf die aV hat.

Dazu wird der indirekten Effekt einer uV über den Mediator auf die aV geschätzt.

Eine Mediationsanalyse ist immer eine kausale Analyse. Das statistische Schätzen von Mediationsmodellen und indirekten Effekten geht immer davon aus, dass das kausale Modelle korrekt identifiziert ist.

Es gibt keine nicht kausale Mediation. Statistisch betrachtet sind Mediator- und Confounder-Variablen austauschbar (MacKinnon et al., 2000)

Daten der heutigen Sitzung

Daten der heutigen Sitzung

Daten der heutigen Sitzung

- Condition: Fact (0), Experience (1)

- Harm: 3 Items, z.B. “causes harm”

- Lie: 3 Items, z.B. “is a lie”

- Censor: 4 Items, z.B. “censor her”

- Behave: 1 Item, “willing to report to Twitter”

- Alle Range 1-7

| Condition | Harm | Lie | Censor | Behave |

|---|---|---|---|---|

| Fact | 3.33 | 5.33 | 1.00 | 4 |

| Fact | 6.00 | 5.00 | 1.00 | 3 |

| Fact | 7.00 | 7.00 | 7.00 | 7 |

| Experience | 4.67 | 3.67 | 3.25 | 3 |

| Experience | 4.33 | 4.00 | 7.00 | 7 |

| Experience | 3.67 | 5.33 | 2.00 | 2 |

Stichprobe

| Variable | Fact (n=198) | Experience (n=199) | Total (n=397) |

|---|---|---|---|

| Mean Age (SD) | 42.66 (13.73) | 43.75 (13.46) | 43.20 (13.59) |

| Gender [female], % | 48.5 | 47.0 | 47.7 |

| Mean Harm (SD) | 4.84 (1.60) | 4.02 (1.73) | 4.43 (1.71) |

| Mean Lie (SD) | 4.99 (1.40) | 3.44 (1.47) | 4.22 (1.63) |

| Mean Censor (SD) | 2.98 (1.72) | 2.27 (1.36) | 2.62 (1.59) |

| Mean Behave (SD) | 3.22 (1.94) | 2.19 (1.45) | 2.70 (1.79) |

Gesamtes Modell

Vereinfachtes Modell als erstes Beispiel

Drei Regressionsmodelle: I

Drei Regressionsmodelle: II

Drei Regressionsmodelle: III

Indirekte, direkte und totale Effekte

- Totaler Effekt des Treatments auf Censorship:

- Effekt des Treatments auf Harmful:

- Effekt von Harmful auf Censorship bei Kontrolle des Treatments:

- Direkter Effekt des Treatments bei Kontrolle von Harmful:

- Indirekter Effekt des Treatments über Harmful:

- Totaler Effekt = Indirekter Effekt + Direkter Effekt:

Fragen?

Gesamtes Modell

Vier Regressionsmodelle: I

Vier Regressionsmodelle: II

Vier Regressionsmodelle: III

Vier Regressionsmodelle: IV

| Parameter | Coefficient | 95% CI | t(393) | p |

|---|---|---|---|---|

| (Intercept) | 0.87 | (0.31, 1.44) | 3.05 | 0.002 |

| Condition (Experience) | -0.20 | (-0.53, 0.12) | -1.23 | 0.218 |

| Harm | 0.21 | (0.11, 0.31) | 4.11 | < .001 |

| Lie | 0.22 | (0.10, 0.33) | 3.61 | < .001 |

Indirekte, direkte und totale Effekte

- Totaler Effekt: ; direkter Effekt:

- Indirekter Effekt über Harmful:

- Indirekter Effekt über False:

Indirekte, direkte und totale Effekte

Der negative Effekt der Begründung mit einer persönlichen Erfahrung im Vergleich zur Begründung mit wissenschaftlichen Fakten auf die Zustimmung zu einer Zensur der Aussage wird durch die Einschätzung der Gefährlichkeit und der Falschheit vermittelt. Die Schilderung einer persönlichen Erfahrung wird als weniger gefährlich und weniger falsch eingeschätzt, was wiederum zu einer verringerten Zustimmung zur Zensur der Aussage führt.

Aber sind diese indirekten Effekte statistisch signifikant?

Schätzen und Inferenzstatistik

Schätzen

- Option 1: Mehrere Regressionsmodelle und spezielle Testverfahren

- Option 2: Ein Strukturgleichungsmodell

Inferenzstatistik

- In 2010er Jahren sehr aktives Forschungsfeld; wir steigen in diesem Rahmen nicht tiefer in die Debatten ein. Für Interessierte: Hayes & Scharkow (2013)

- Heute stärkerer Fokus auf Annahmen für Identifikation kausaler Effekte

Strukturgleichungsmodelle

- Englisch Structural Equation Models (daher Abkürzung SEM gebräuchlich)

- Schätzung von mehreren Gleichungen in einem Modell

- Schätzung meist mit Maximum-Likelihood-Verfahren und deren Varianten

- Wesentliche Vorteile gegenüber mehreren Regressionsmodellen:

- Einfach zu spezifizieren und trotzdem sehr flexibel

- Statistische Tests für selbst definierte Paramenter, z.B. indirekte Effekte

- Messmodelle: Latente Variablen aus Indikatoren schätzen

Strukturgleichungsmodelle

- Hier nur konzeptionelle und praktische Einführung zur Mediationsanalyse

- Einstieg in die Vertiefung (nicht klausurrelevant):

- Inhaltlich: Arzheimer (2016) (kein R)

- Technisch mit R: UCLA Statistical Consulting Group

Ein Pfadmodell

modell <- "

# Modelle

# Mediator 1: Harm

Harm ~ a1 * Condition

# Mediator 2: False

Lie ~ a2 * Condition

# aV: Endorsement of Censorship

Censor ~ c_ * Condition + b1 * Harm + b2 * Lie

# Kovarianz zwischen Mediatoren

Harm ~~ Lie

# Effekte

# Indirekte Effekte

indirect_harm := a1 * b1

indirect_lie := a2 * b2

# Direkter Effekt

direct := c_

# Totaler Effekt

total := direct + indirect_harm + indirect_lie

"Mediation im Pfadmodell

| Parameter | Coefficient | CI | z | p |

|---|---|---|---|---|

| Harm ~ Condition | -0.81 | (-1.14, -0.49) | -4.88 | < .001 |

| Lie ~ Condition | -1.55 | (-1.83, -1.27) | -10.77 | < .001 |

| Censor ~ Condition | -0.20 | (-0.52, 0.12) | -1.24 | 0.215 |

| Censor ~ Harm | 0.21 | (0.11, 0.31) | 4.13 | < .001 |

| Censor ~ Lie | 0.22 | (0.10, 0.33) | 3.62 | < .001 |

Mediation im Pfadmodell

| Parameter | Coefficient | CI | z | p |

|---|---|---|---|---|

| indirect_harm := a1*b1 | -0.17 | (-0.28, -0.07) | -3.16 | 0.002 |

| indirect_lie := a2*b2 | -0.33 | (-0.53, -0.14) | -3.44 | < .001 |

| direct := c_ | -0.20 | (-0.52, 0.12) | -1.24 | 0.215 |

| total := direct+indirect_harm+indirect_lie | -0.71 | (-1.02, -0.41) | -4.57 | < .001 |

Der negative Effekt der Begründung mit einer persönlichen Erfahrung im Vergleich zur Begründung mit wissenschaftlichen Fakten auf die Zustimmung zu einer Zensur der Aussage wird durch die Einschätzung der Gefährlichkeit und der Falschheit vermittelt. Die Schilderung einer persönlichen Erfahrung wird als weniger gefährlich und weniger falsch eingeschätzt, was wiederum zu einer verringerten Zustimmung zur Zensur der Aussage führt.

Die indirekten Effekte vermittelt über die Einschätzung der Gefährlichkeit (, 95%-KI , , ) und der Falschheit (, 95%-KI , , ) sind statistisch signifikant.

Kausale Identifikation des Modells?

- Randomisierte Zuteilung des Treatments: Identifikation durch Design

- Gemessene Mediatoren: Identifikation durch theoretische Annahme

- Da keine Kontrollvariablen im Modell sind, gilt die starke Annahme, dass es keine Confounder zwischen den Mediatoren und der aV gibt.

Ausblick (nicht behandelt): Messmodelle in Strukturgleichungsmodellen

Messmodelle

In den Sozialwissenschaften interessieren wir uns häufig für latente Konstrukte, die wir nicht direkt beobachten können. Wir messen daher häufig mehrere manifeste Indikatoren, die gemeinsam das Konstrukt abdecken sollen.

Kausale Betrachtung: Wir gehen davon aus, dass das Konstrukt die Indikatoren beeinflusst.

Häufig werden die Indikatoren zu einem Index (Mittelwertindex, Summenindex) verrechnet, der dann als neue Variable im Datensatz vorkommt und in Modellen verwendet wird.

- Nachteile: Alle Indikatoren gehen mit gleichem Gewicht in den Index ein. Messfehler werden nicht berücksichtigt.

Messmodelle im Rahmen von Strukturgleichungsmodellen modellieren den kausalen Prozess explizit

- Vorteile: Messfehler und unterschiedliche Gewichte werden aus den Daten geschätzt; Ausführliche Diagnose der Qualität der Messung möglich

Messmodelle in {lavaan}

modell2 <- "

# Konstrukte

Harm =~ Harm_1 + Harm_2 + Harm_3

Lie =~ Lie_1 + Lie_2 + Lie_3

Censor =~ Censorship_1 + Censorship_2 + Censorship_3 + Censorship_4

# Korrelation zwischen Konstrukten

Harm ~~ Lie

# Modelle

# Mediator 1: Harm

Harm ~ a1 * Condition

# Mediator 2: False

Lie ~ a2 * Condition

# aV: Endorsement of Censorship

Censor ~ c_ * Condition + b1 * Harm + b2 * Lie

# Effekte

# Indirekte Effekte

indirect_harm := a1 * b1

indirect_lie := a2 * b2

# Direkter Effekt

direct := c_

# Totaler Effekt

total := direct + indirect_harm + indirect_lie

"

modell2_fit <- sem(modell2, data = select(d, -Harm, -Lie, -Censor)) Grafische Darstellung mit Messmodellen

Ergebnisse: Messmodelle

| Parameter | Coefficient | CI | z | p |

|---|---|---|---|---|

| Harm =~ Harm_1 | 0.96 | (0.94, 0.97) | 142.74 | < .001 |

| Harm =~ Harm_2 | 0.96 | (0.94, 0.97) | 143.14 | < .001 |

| Harm =~ Harm_3 | 0.91 | (0.89, 0.93) | 88.13 | < .001 |

| Lie =~ Lie_1 | 0.96 | (0.94, 0.97) | 145.69 | < .001 |

| Lie =~ Lie_2 | 0.93 | (0.92, 0.95) | 112.88 | < .001 |

| Lie =~ Lie_3 | 0.93 | (0.91, 0.94) | 107.06 | < .001 |

| Censor =~ Censorship_1 | 0.92 | (0.91, 0.94) | 113.16 | < .001 |

| Censor =~ Censorship_2 | 0.97 | (0.96, 0.97) | 219.09 | < .001 |

| Censor =~ Censorship_3 | 0.96 | (0.96, 0.97) | 212.10 | < .001 |

| Censor =~ Censorship_4 | 0.95 | (0.94, 0.97) | 179.95 | < .001 |

Ergebnisse: Pfadmodell

| Parameter | Coefficient | CI | z | p | Label |

|---|---|---|---|---|---|

| Harm ~ Condition | -0.83 | (-1.16, -0.50) | -4.94 | < .001 | a1 |

| Lie ~ Condition | -1.57 | (-1.86, -1.28) | -10.69 | < .001 | a2 |

| Censor ~ Condition | -0.18 | (-0.49, 0.14) | -1.08 | 0.279 | c_ |

| Censor ~ Harm | 0.23 | (0.12, 0.33) | 4.21 | < .001 | b1 |

| Censor ~ Lie | 0.20 | (0.08, 0.32) | 3.21 | 0.001 | b2 |

| indirect_harm := a1*b1 | -0.19 | (-0.30, -0.07) | -3.21 | 0.001 | indirect_harm |

| indirect_lie := a2*b2 | -0.32 | (-0.52, -0.12) | -3.08 | 0.002 | indirect_lie |

| direct := c_ | -0.18 | (-0.49, 0.14) | -1.08 | 0.279 | direct |

| total := direct+indirect_harm+indirect_lie | -0.68 | (-0.98, -0.38) | -4.48 | < .001 | total |

Ergebnisse: Modellpassung

| Parameter | Fit |

|---|---|

| RMSEA | 0.05 |

| CFI | 0.99 |

| NFI | 0.99 |

| SRMR | 0.02 |

The RMSEA (.05 < .05) suggest a satisfactory fit.

The CFI (.99 > .90) suggest a satisfactory fit.

The NFI (.99 > .90) suggest a satisfactory fit.

The SRMR (.02 < .08) suggest a satisfactory fit.

Fragen?

Fazit

Mediationsanalyse sieht leicht aus, ist aber schwer.

Mediationsmodelle sind in der Regel sehr leicht zu spezifizieren und lassen sich auf den ersten Blick intuitiv interpretieren. Allerdings sind sehr starke theoretische Annahmen nötig, um die kausalen Effekte zu identifizieren.

- Das gilt auch dann, wenn das Treatment in einem Experimentaldesign randomisiert wird.

- Mediationsanalysen auf Basis von reinen Querschnittsdesigns sollten grundsätzlich ignoriert werden.

Die statistisch geschätzten Effekte basieren auf der Annahme, dass das zugrunde liegende kausale Modell korrekt ist. Das statistische Modell kann diese Annahme nicht prüfen.

“Yes, but what’s the mechanism? (don’t expect an easy answer)” — Bullock et al. (2010)

“That’s a lot to process! Pitfalls of popular path models” — Rohrer et al. (2022)

Fragen?

Übungsaufgaben

Übungsaufgaben

Ohne R! Interpretieren Sie die Regressionsmodelle in Van Erkel & Van Aelst (2021) vor dem Hintergrund der kausalen Annahmen. Welche Koeffizienten würden Sie in diesen Modellen interpretieren, welche nicht? Wie müsste ein Modell aussehen, in dem Sie einen kausalen Effekt von Politisches Interesse interpretieren würden? Wie eines zur Identifikation des kausalen Effekts von Bildung?

Reproduzieren Sie das Strukturgleichungsmodel aus der Vorlesung. Interpretieren Sie die Ergebnisse und vergleichen Sie Ihre Interpretation mit Kubin et al. (2025).

Modifizieren Sie die Mediationsanalyse mit einem Strukturgleichungsmodell. Ersetzen Sie die abhängige Variable durch das Melden des Tweets (

Behave) aus der Vorlesung. Schätzen Sie das Strukturgleichungsmodell. Interpretieren Sie die Ergebnisse in einigen Sätzen. Vergleichen Sie Ihre Interpretation mit Kubin et al. (2025).

- Stellen Sie Ihre Fragen (egal ob technisch oder statistisch) im Blackboard-Forum.

Übungsaufgaben: Technische Anleitung

[Beschreibung für R und RStudio auf eigenem Computer oder Pool-Computer]

- Laden Sie die Dateien

06_mame.RundKubin_etal_2025.xlsxaus Blackboard herunter. Speichern Sie die Datei06_mame.Rin Ihren Arbeitsordner für die Vorlesung (in denselben Ordner, in dem die.R-Dateien aus den letzten Übungen liegen). Speichern SieKubin_etal_2025.xlsxin den UnterordnerDaten(in denselben Ordner, in demVanerkel_Vanaelst_2021.dtaliegt.) - Öffnen Sie das Projekt

uebung.Rproj. - Öffnen Sie innerhalb des Projekts die Datei

06_mame.R.

Übungsaufgaben: Technische Anleitung

[Beschreibung für WebR]

- Laden Sie die Dateien

06_mame.RundKubin_etal_2025.xlsxaus Blackboard herunter. - Laden Sie die Dateien

06_mame.RundKubin_etal_2025.xlsxin den Ordnerhome/web_userhoch. - Öffnen Sie die Datei

06_mame.R. - Ändern Sie den Befehl zum Laden der Datei: Löschen Sie

daten/.

Übungsaufgaben: Technische Anleitung

[Beschreibung für Posit.Cloud]

- Laden Sie die Dateien

06_mame.RundKubin_etal_2025.xlsxaus Blackboard herunter. - Öffnen Sie das RStudio-Projekt, das Sie zur ersten Übung erstellt haben, in Posit-Cloud.

- Laden Sie die Datei

06_mame.Rin den Ordneruebunghoch. Laden Sie die DateiKubin_etal_2025.xlsxin den Unterordnerdatenhoch. - Öffnen Sie das Projekt

uebung.Rprojund innerhalb des Projekts die Datei06_mame.R. - Ändern Sie den Befehl zum Laden der Datei: Fügen Sie

uebung/vordaten/ein.

Fragen?

Nächste Woche

Mehrebenenmodelle

Danke — bis zur nächsten Sitzung.

Marko Bachl